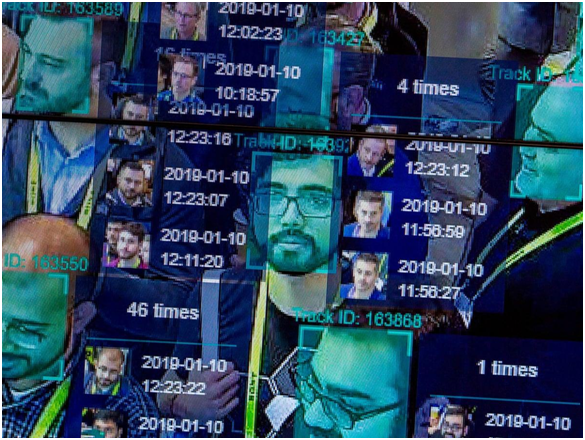

التعرف على الوجه لقد تطورت التكنولوجيا وقدراتها بعيدًا عن مخيلتنا منذ أن أصبحت الخوارزميات الجديدة لتعزيز هذه التقنية في إنفاذ القانون في الصدارة. في الوقت الحالي ، تستخدم قوات إنفاذ القانون تقنية التعرف على الوجوه على أدنى مستويات عمليات جمع البيانات لتحديد المجرمين الإجراميين وسط التجمعات المزدحمة. تستخدم التكنولوجيا لقطات من كاميرات الدوائر التلفزيونية المغلقة في الأماكن العامة والشوارع ثم تقوم بتشغيل البيانات التي تم جمعها ضد أرشيفات الوكالة للكشف عن وجه مطلوب لجرائم جنائية.

تم دمج هذه التقنية أيضًا في أصغر الأدوات ، بما في ذلك الهواتف المحمولة والأجهزة الذكية القابلة للارتداء. وبالتالي ، فهو لا يحميك في الشوارع فحسب ، بل ينوي أيضًا حماية معلوماتك الشخصية المخزنة على أجهزتك الذكية. أصبح استخدام "بصمة الوجه" في ممارسات التسويق والإعلان أمرًا شائعًا في العصر الحديث لحملة وسائل التواصل الاجتماعي. ثم هناك مراقبة خاصة في مراكز التسوق ومحلات البيع بالتجزئة ، إلخ.

من هذا المنظور ، يمكن للمرء أن يشير بسرعة إلى المزايا التي لا يمكن إنكارها لتقنية التعرف على الوجه. ولكن تم فحصه أيضًا للتهديد الذي يمثله لخصوصية المستخدم وحماية البيانات ، وبالطبع الشفافية بين القانون والجمهور. من الجيد أن تكون على دراية بكل من مزايا وعيوب هذه التقنية الغازية. ومع ذلك ، هناك عيب آخر في تقنية التعرف على الوجوه ، والتي يبدو أن الناس يتجاهلونها ، وهذا هو التنميط العنصري والتمييز العنصري.

في هذه المقالة ، ننظر إلى كيفية تعزيز هذه التقنية للتحيز العنصري والتمييز ومدى خطورة تداعيات هذه التكنولوجيا الغازية.

كيف يعمل التعرف على الوجه؟

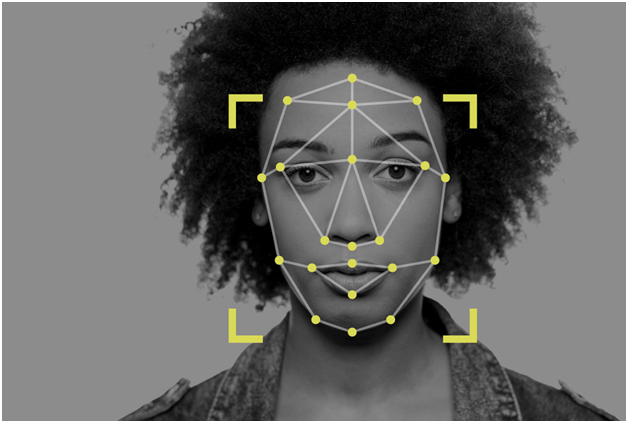

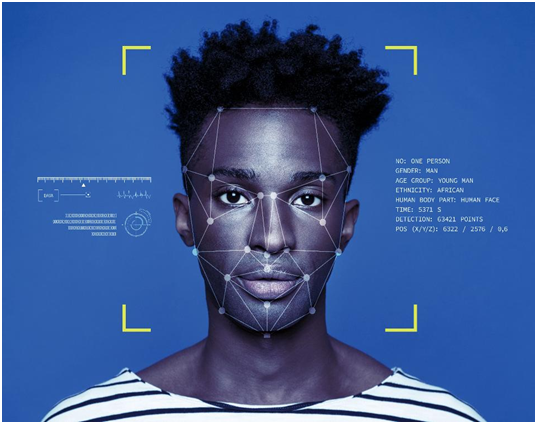

الخطوة 1: يتم التقاط صورة لك من كاميرا أو حسابك أو بريدك الإلكتروني ، إلخ. إما أن تكون صورة ملف شخصي مستقيمة أو لقطة عشوائية وسط حشد من الناس.

الخطوة 2: سيقوم برنامج التعرف على الوجوه بتشغيل وجهك من خلال قاعدة بيانات لبصمات الوجوه المخزنة. يتم جمع بصمة الوجه من خلال التتبع الهندسي لوجهك.

الخطوه 3: يتم إنتاج نسبة مطابقة لصورتك مقابل أي بصمة وجه معروفة باستخدام خوارزمية يتم تحديدها.

تحيز الأتمتة: أحد العيوب العديدة في تقنية التعرف على الوجه

يشير التحيز الآلي أو التحيز الآلي إلى السيناريو الذي تظهر فيه خوارزمية الآلة انحيازًا معينًا في معايرة بيانات الإدخال ، مما يعطي مخرجات غير مواتية. يحدث هذا عندما يكون هناك خطأ في رمز الخوارزمية ، أو نقص مجموعات البيانات المخزنة للمعايرة ، أو قيم الإدخال غير الصحيحة ، أو بيانات الإدخال الزائدة ، وهو ما يتجاوز قوة الأجهزة للمعايرة.

كيف تسير التنميط العنصري مع كل هذا؟

مصدر الصورة: الجارديان

مصدر الصورة: الجارديانلنبدأ بحادث قديم اعتبر في ذلك الوقت غير ذي أهمية. في عام 2001 ، استخدمت مدينة تامبا برنامج التعرف على الوجوه للمراقبة على المدينة المزدحمة حيث غمر السياح شوارع المدينة بسبب سوبر بول 2001. حسب تقرير نيويورك تايمز، حدد البرنامج 19 شخصًا يفترض أن لديهم مذكرات معلقة ضدهم ؛ ومع ذلك ، لم يتم إجراء أي اعتقالات لأن البنية التحتية للملعب جعلت من المستحيل الوصول إلى الجناة الذين تم تحديدهم بين جمهور غامر.

في حين لم تظهر علامات التنميط العنصري في أي مكان في هذه الحالة بالذات ، كانت هذه هي المرة الأولى التي تطرح فيها تقنيات المراقبة ضد انتهاك الحريات المدنية والخصوصية للأفراد. في السنوات القادمة ، تخلت شرطة تامبا عن أنظمة المراقبة هذه مستشهدة بنتائج غير موثوقة.

مصدر الصورة: ICO

مصدر الصورة: ICOالتقديم السريع لسيناريو أحدث إلى حد ما ، تقرير علي بريلاند لصحيفة الغارديان، فيما يتعلق باعتقال ويلي لينش ، وهو رجل أسود متهم بكونه تاجر مخدرات سيئ السمعة في منطقة برينتوود ، في الغالب هو حي من الملونين. كان الدليل الوحيد ضد لينش هو صوره على هاتف محمول ، والتي تم تشغيلها على قاعدة بيانات للشرطة قبل أن تقرر الشرطة أنه الجاني. أدين لينش لمدة ثماني سنوات ، وقد استأنف ضد الإدانة الآن. سواء كان تاجرًا مزعومًا أم لا ، فإنه يثير حتمًا مخاوف بشأن ما إذا كانت النتيجة الآلية فقط كافية لدعم إدانة أي شخص قيد التحقيق؟

في عام 2019 ، وفقًا لما أوردته توم بيركنز لصحيفة الغارديان، تم العثور على شرطة ديترويت باستخدام التعرف على الوجوه لإجراء اعتقالات مزعومة خلال العامين الماضيين. ديترويت هي مكان يعيش فيه أكثر من 80٪ من السكان من السود. أثار بيان من عضو أسود من لجنة شرطة ديترويت مخاوف ضد هذه الممارسة. وقال إن السود لديهم سمة مشتركة للوجه تهدد خوارزمية النظام ، واصفة ذلك بـ "العنصرية التقنية".

مصدر الصورة: Vox

مصدر الصورة: Voxفي بحث أجرته مجلة Journal of Information Communication and Ethics Society في عام 2019 ، من قبل Fabio Bacchini و Ludovica Lorusso ، وجد أن أنظمة التعرف على الوجه والميزات الحيوية هذه ليست موثوقة بنسبة 100 ٪ لإنفاذ القانون. علاوة على ذلك ، كان للتمييز العنصري تأثير سلبي على جميع هذه النظم ، مما أدى إلى انعكاسات اجتماعية أكبر. استهدفت الدراسة المجتمعات الغربية على وجه الخصوص ، حيث يتم استخدام هذه الأنظمة على نطاق واسع للمراقبة.

هذه ليست سوى ثلاثة من العديد من هذه الأمثلة حيث ظهرت حالات التفاوت العنصري الناجم عن أنظمة التعرف على الوجوه. ولكن لماذا هذه الأنظمة غير كفؤة للغاية على الرغم من هذه الدقة المتزايدة في ترميزات الترميز الخوارزمي في التكنولوجيا.

التفوق الأبيض في الدول الغربية: صناعة تقنية بيضاء مهيمنة

في عام 2014 ، أغلبية شركات التكنولوجيا ، بما في ذلك العملاق Apple Inc ، تم توظيفهم في الغالب من الرجال البيض. في Apple، 55٪ من الموظفين كانوا من البيض ، وبالمثل ، Apple شكلت القيادة 63 ٪ من الموظفين البيض. وشملت الشركات التي شاركت تقارير التنوع مماثلة Facebookو Google و Twitter كذلك. بعد خمس سنوات ، كشف تقرير في Wired عن حدوث تحسن طفيف في هذه الأرقام.

في حين Facebook أظهر تحسنا كبيرا في الأرقام ، Appleلم تتغير نسبة العمال التقنيين السود بنسبة 6٪ فقط من إجمالي القوى العاملة. Amazon كانت المنظمة الوحيدة التي سجلت 42٪ من العاملين السود أو أمريكا اللاتينية في مكاتبها في الولايات المتحدة.

ما يموت يموت هذه الإحصائيات؟ في الولايات المتحدة ، معظم المبرمجين ، الذين تم تعيينهم لمشاريع كبيرة مثل تصميم خوارزميات لأنظمة المراقبة ، هم من البيض. هؤلاء هم الأشخاص الذين يتخذون أهم القرارات المتعلقة بمنتج أو خدمة يتم إطلاقها / الكشف عنها من قبل شركة. وبالتالي ، فإن وجهات نظرهم ، ونهجهم ، وعمليات التفكير التي تسير في الخلق النهائي. هذا لا يعني أن البيض هم عنصريون وقد صمموا عن قصد أنظمة المراقبة هذه. لا!

مصدر الصورة: فوربس

مصدر الصورة: فوربسعندما يصمم رجل أبيض خوارزمية التعرف على الوجوه ولا يستشيره / يساعده سوى الزملاء البيض ، فإنهم لا يأخذون في الاعتبار أشخاصًا ذوي سمات لون أخرى قبل إنهاء الرمز. نظرًا لأن المهندسين البيض يسيطرون على صناعة التكنولوجيا ، فإن أرشيفات البيانات المستخدمة لإعداد الكود الأولي يتم إنشاؤها ومعايرتها أيضًا من قبل الفنيين البيض. وهكذا ، تم إنشاء الكود نفسه مع التحيز في خوارزمية حسابية أساسية ، مما أدى إلى هذه التفاوتات العرقية في نتائج المراقبة.

يتعلم الرمز ببساطة ما يجسده البيض. لا يوجد منظور أو مساهمة من أي شخص من لون آخر.

قضايا المعايرة

يعتمد تطبيق القانون الأمريكي بشكل كبير على المراقبة وتتبع البيانات. كانت هناك حالات كثيرة أزال فيها المبلغون عن المعلومات المتعلقة بالمراقبة غير القانونية للمدنيين. إن كشف إدوارد سنودن عن مراقبة وكالة الأمن القومي غير القانونية هو أحد الأمثلة على ذلك.

مصدر الصورة: CBS Local

مصدر الصورة: CBS Localبرامج المراقبة هذه مدعومة ببصمات وجه ومعلومات شخصية أخرى لملايين المواطنين. إذا أخذنا بعين الاعتبار فقط بصمات الوجوه ، فهناك ملايين الأمريكيين يشاركون الصور بشكل علني على منصات التواصل الاجتماعي. ثم هناك كاميرات CCTV في كل شارع في الدولة تقدم لقطات حية لمئات الآلاف من المارة. حاليا ، هناك ما يقرب من 117 مليون صورة في قواعد بيانات الشرطة ، بينما لدى مكتب التحقيقات الفدرالي أكثر من 400 مليون مجموعة بيانات للمعايرة في خوارزميات التعرف على وجه المراقبة.

تخيل الآن مجموعات البيانات هذه مقارنةً بصورة واحدة قد تكون أو لم تلتقط جميع سمات الوجه للشخص المحدد. في مثل هذا السيناريو ، من المرجح أن تنشأ أخطاء. هناك الكثير من البيانات لفهمها وتشغيلها مقابل بصمة واحدة. لا يمكن لأي خوارزمية ضمان ضمان مائة بالمائة في نتيجتها عندما تكون المعايرة معقدة للغاية. هذا يضيف في النهاية إلى التنميط العنصري الناجم عن تقنية التعرف على الوجوه.

الموثوقية الهائلة في التعرف على الوجه

مصدر الصورة: NY Post

مصدر الصورة: NY Postإن حالة ويلي لينش هي تذكير بأن التعرف على الوجه لا ينبغي أن يكون التقنية الوحيدة الموثوقة المقدمة كدليل عندما يتعلق الأمر بإنفاذ القانون. هذا هو السبب في تخلي شرطة مدينة تامبا عن التكنولوجيا.

صحيح أن التعرف على الوجه هو منتجع ممتاز ومفيد للشرطة. تم التعرف على الجناة تفجيرات بوسطن ماراثون باستخدام تحليل شامل ومفصل لتسجيلات المراقبة. لكن هذا لا يمكن أن يكون الدليل الوحيد لإدانة أي شخص. يجب أن تكون هناك أدلة داعمة لإثبات نتائج خوارزميات التعرف على الوجه ، ويجب النظر في مفهوم التحيز الآلي قبل الوصول إلى قرار نهائي.

مشكلة الأجهزة: التعرف على الوجه في الهاتف المحمول والكاميرات

مصدر الصورة: TechCrunch

مصدر الصورة: TechCrunchإن أنظمة كاميرات المراقبة والأجهزة والبرامج المرتبطة بها غير مصممة من قبل شركة واحدة. إنها صناعة تبلغ قيمتها مليارات الدولارات حيث تتنافس عشرات الشركات للحصول على عقود من وكالات إنفاذ القانون. العديد من هذه الأنظمة من الشركات المصنعة الصينية. الأمر كله يتعلق بالحصول على أرخص التقنيات بأفضل الصفات. هكذا تعمل في الغالب. وبالتالي ، هناك دائمًا فرص للاختلافات في معايرة الأنظمة المختلفة ، فضلاً عن الاختلاف في جودة نتائج المراقبة. العديد من خوارزميات مراقبة الكاميرا غير فعالة في معايرة صور الأشخاص الملونين فقط بسبب عدم الكفاءة التقنية ، وبالتالي تمجيد التمييز العنصري.

كما لوحظت المشاكل التقنية التي تسبب العنصرية من خلال التعرف على الوجوه في Apple ميزة قفل الوجه. خلصت قضية من الصين إلى أن قفل الوجه لجهاز iPhone X لم يكن قادرًا على التمييز بين زملاء عمل صينيين مختلفين ، مما يجعل هذه الميزة عديمة الفائدة. تم رفض تقارير مماثلة ، مشيرة إلى مشاكل في الميزة في فصل شخصين سود عن بعضهما البعض. كما ذكر أعلاه، Apple لديها 6٪ فقط من السود في الفرق الفنية. إنه مثال واضح على كيف يمكن لتقنية التعرف على الوجوه أن تعزز العنصرية حتى في أجهزتنا المحمولة.

استنتاج

نعم ، التعرف على الوجوه عنصري ، وهذه معرفة شائعة الآن. وبينما تنمو التكنولوجيا يوميًا لتصحيح هذه المشكلات ، فإن النتائج متشابهة. من المفترض أن توحد التكنولوجيا العالم حول الأهداف المشتركة للتقدم التقني والتنمية ، ولكن بعض التقنيات تسبب فقط ضررًا للتناغم العرقي والجماعي.

في الوقت الحالي ، أفضل شيء يمكن أن يفعله المسؤولون عن تطبيق القانون هو عدم دعم قضاياهم استنادًا إلى أدلة من معايرات الخوارزمية ، والتي لا يمكن الاعتماد عليها حتى. علاوة على ذلك ، فقد حان الوقت لأن يؤخذ التنوع والاندماج في أماكن العمل على محمل الجد بحيث يمكن للناس من جميع الأعراق أن يجتمعوا لإنشاء منتج خال من التفاوتات العرقية. هناك الآلاف من الأجناس في العالم ، وقد نما الناس لوضع الاختلافات العرقية جانبا ، والتي طاردت المجتمع العالمي لفترة طويلة. إذا كان يجب الحفاظ على ذلك ، فيجب أن يتم تعليم الآلات التي نعتمد عليها أنفسنا كثيرًا بنفس الطريقة.