يمكنك تسميتها “تجزئة الصورة”. ولكن بعد ذلك 90٪ من الناس يقولون ، “هاه؟” ثم يمكنك المضي قدمًا وشرح الفرق مع أدوات التجسس لفترة طويلة جدًا ومملة. الطعام جاف جدًا بالنسبة لمعظم الناس. لكن بالنسبة للمتحمسين: هذا ما Apple في الواقع يفعل:

مسح مكتبة الصور.

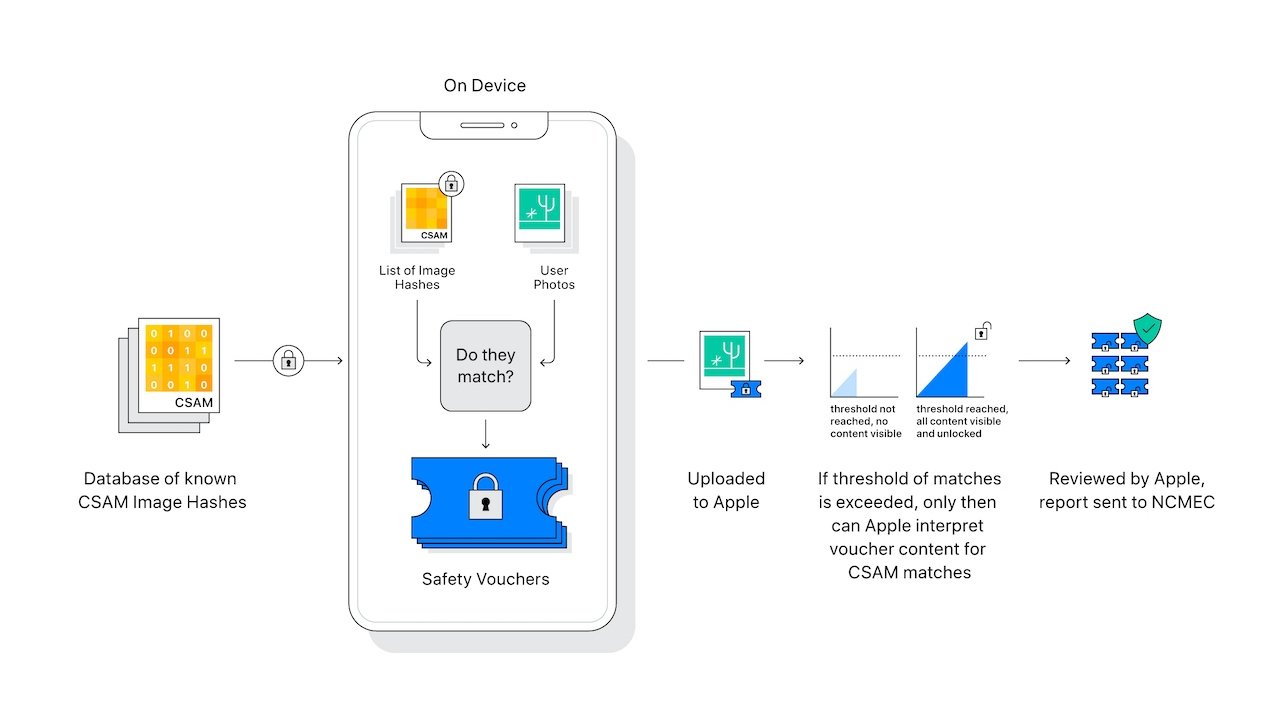

فقط الصور المنقولة من مكتبة الصور الخاصة بك إلى خوادم iCloud Apple يتم تحميلها وفحصها من خلال إنشاء تجزئة للصورة ومقارنتها بقائمة تجزئة لصور الاعتداء الجنسي على الأطفال المعروفة. فقط تلك التجزئات التي تتطابق مع تجزئات صور الاعتداء الجنسي على الأطفال المعروفة يتم تمييزها على أنها انتهاكات محتملة من خلال إنشاء تشفير قسائم الأمان مع البيانات الوصفية والمشتقات المرئية للصور المتطابقة.Apple-لا يعرف الموظفون أي شيء على الإطلاق عن الصور التي لم يتم تحميلها Appleالخوادم – ولا يعرفون أي شيء عن الصور التي لا تتطابق مع تجزئة صور الاعتداء الجنسي على الأطفال المعروفة. إن فرص قيام النظام بوضع علامة على حساب بشكل غير صحيح منخفضة للغاية (1 في 1 تريليون). فقط الحسابات التي تحتوي على قسائم أمان تتجاوز العتبة من عدة مباريات يمكن تقييمها Appleالموظفين – حتى يتم تجاوز الحد الأدنى ، لا يمكن لأي شخص الاطلاع على القسائم المشفرة. ولا يمكن للمستخدمين الوصول إلى قاعدة بيانات صور الاعتداء الجنسي على الأطفال أو عرضها – ولا يمكنهم تحديد الصور التي تم الإبلاغ عنها. فقط الصور التي تمت مراجعتها والتحقق منها على أنها الاعتداء الجنسي على الأطفال ، إلى السلطات.

حماية الطفل في الرسائل.

هذه الميزة متاحة فقط للحسابات التي تم إعدادها كعائلة مع iCloud Family Sharing. يجب على حسابات الوالدين تسجيل الدخول لتمكين الميزة لمجموعة العائلة الخاصة بهم. لا يمكن تشغيل إشعارات الوالدين إلا من قبل الوالدين / الأوصياء لحسابات الأطفال الذين يبلغون من العمر 12 عامًا أو أقل. عند التمكين ، تستخدم الميزة AI على الجهاز (بدلاً من قاعدة بيانات التجزئة المذكورة أعلاه) لتحليل الصور المرسلة والمستلمة من قبل الطفل – ويتم ذلك بشكل خاص بحيث Apple إذا كان حساب الطفل يرسل أو يستقبل صورًا جنسية فاضحة ، فإن الصورة غير واضحة ويتم تنبيه الطفل ، ويقدم له موارد مفيدة ، ويطمئن أنه لا بأس إذا كان هو أو هي لا يريد عرض أو إرسال الصورة. يجب التسجيل) ، كإجراء احترازي إضافي ، يمكن أيضًا إخبار الأطفال الصغار أنه للتأكد من سلامتهم ، سيتم إخطار والديهم عند مشاهدته.

إذا كان الأشخاص قلقين بشأن نشاط المطابقة هذا ، فيمكنهم إلغاء الاشتراك من خلال عدم تحميل الصور على iCloud (عن طريق تعطيل iCloud Photos و My Photo Stream و iMessage). نظرًا لأن هذه كلها خدمات اختيارية ، فإن الانسحاب سهل للغاية. يدعي ذلك Apple يفترض أن يقوم بمسح جهازك بالكامل على مدار الساعة طوال أيام الأسبوع لا أساس له من الصحة. يدعي ذلك Apple مسح كل صورة على جهازك لا أساس لها.

الأطفال ضعفاء ويستحقون حمايتنا كمجتمع. ماذا Apple محاولة القيام بذلك أمر مشرف ، وهم يذهبون إلى أبعد الحدود لحماية خصوصيتنا مع حماية الأطفال الضعفاء من سوء المعاملة. لسوء الحظ ، هناك قسم كبير ورجعي إلى حد ما من المجتمع يبدو غير قادر (أو غير راغب في) النظر إلى ما وراء عناوين clickbait ، ويرغب في إصدار حكم من موقع الجهل. وهكذا يجب Apple التعامل مع هذا الموضوع بقفازات مخملية. كما يشير ذلك أيضًا إلى أن Microsoft و Google Facebook يقوم وآخرون بمسح جميع صور مستخدميهم على CSAM لعقود ، ولكن الآن فقط Apple سيفعل ذلك ، نرى الكثير من “الغضب”. بالإضافة إلى ذلك ، على عكس هذه الشركات الأخرى Apple بذل قصارى جهده لتنفيذ نظام تقاطع مجموعة خاصة (PSI) آمن مشفرًا يفحص الصور الموجودة على الجهاز من قبل Apple إذا كان بإمكان أي شخص آخر رؤية الصور الفعلية. يتم تحريف هذا الأمر باعتباره “شيئًا سيئًا” في حين أنه في الواقع يحافظ على الخصوصية بشكل أفضل بكثير من المنافسة.

Apple لا تفعل هذا من أجل المتعة ، وليس لأنهم يريدون تسييل بياناتنا (على عكس بعض الشركات الأخرى المذكورة أعلاه ، والتي تمثل نموذج الإيرادات القياسي بالنسبة لها). Apple يفعل ذلك لأنه تم العثور على المواد الإباحية للأطفال في جميع خدمات استضافة الصور الرئيسية تقريبًا ، وهذا هو سبب إجبار العديد من الشركات على استخدام هذه الأنواع من الأنظمة لاكتشافها. يبقى الاختلاف الكبير: مع Apple لا تزال خصوصيتي هي نقطة البيع الفريدة.

أبل

ما تحتاج إلى معرفته: Appleسلامة الطفل في صور ورسائل iCloud …

منذ ذلك الحين Apple أعلنت عن تقييم صور iCloud Photos الخاص بسلامة الأطفال وإشعارات الرسائل ، لم تكن هناك أي تغييرات ، ولكن كانت هناك توضيحات كثيرة من الشركة حول هذا الموضوع. إليك ما تحتاج إلى معرفته ، …

Apple

سلامة الطفل

الحماية الموسعة للأطفال

en.wikipedia.org

فوتودنا

PhotoDNA هي تقنية لتعريف الصور تُستخدم للكشف عن المواد الإباحية للأطفال وغيرها من المحتويات غير القانونية التي يتم الإبلاغ عنها إلى المركز الوطني للأطفال المفقودين والمستغلين (NCMEC) وفقًا لما يقتضيه القانون. تم تطويره بواسطة Microsoft Research و Hany Farid ، الأستاذ بكلية Dartmouth ، بداية من عام 2009. من قاعدة بيانات للصور وملفات الفيديو غير القانونية المعروفة ، يقوم بإنشاء تجزئات فريدة لتمثيل كل صورة ، والتي يمكن استخدامها بعد ذلك لتحديد الأمثلة الأخرى لهذه الصور. صورة فوتوغرافية…

https://inhope.org/EN/articles/what-is-image-hashing